Poczucie pewności napędza efekt potwierdzenia

Ludzkie procesy myślowe są potężne, ale mają wady, jak system GPS, który używa popsutego algorytmu i prowadzi cię w złym kierunku. Psycholodzy badają te błędy poznawcze i wzory heurystyczne, żeby lepiej zrozumieć wady i proponować możliwe środki zaradcze. W dużym stopniu naukowy sceptycyzm traktuje właśnie o tym – jest to identyfikowanie i rekompensowanie tych skaz ludzkiego poznania.

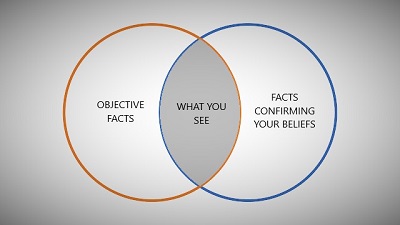

Być może matką wszystkich błędów poznawczych jest efekt potwierdzenia – tendencja do zauważania, akceptowania i pamiętania informacji, która potwierdza to, w co już wierzymy (lub może, chcemy wierzyć) oraz ignorowanie, odrzucanie lub zapominanie informacji, które zaprzeczają temu, w co wierzymy. Efekt potwierdzenia jest niewidzialną siłą, nieustannie działającą w tle, kiedy normalnie funkcjonujemy w życiu, zbierając informacje i cyzelując nasze modele rzeczywistości. Niestety jednak, nie prowadzi nas do poprawności ani obiektywnej informacji. Kieruje nas na drogę własnych, już istniejących w nas narracji.

Jedną z rzeczy, która czyni efekt potwierdzenia czymś tak potężnym, jest to, że daje namz złudzenie wiedzy, które fałszywie wzmacnia naszą pewność co do naszej narracji. Myślimy, że są całe tony dowodów na poparcie naszego przekonania i każdy, kto mu zaprzecza, jest ślepym i głupim ignorantem. Te dowody jednak zostały selektywnie wyciągnięte ze znacznie większego zestawu dowodów, który może mówić coś zupełnie innego niż ten, który widzimy. To jest jak czytanie książki, ale tworzenie własnej akcji po przeczytaniu kilku wybranych słów i zestawieniu ich w inną narrację.

Nowe badanie dodaje więcej informacji o naszym rozumieniu efektu potwierdzenia. Nie tylko potwierdza nasze wybiórcze przetwarzanie potwierdzającej informacji, pokazuje, że poczucie pewności napędza ten proces. A więc nie tylko efekt potwierdzenia prowadzi do fałszywej pewności, ale ta pewność napędza więcej efektów potwierdzenia w samowzmacniającym się cyklu.

Badacze użyli prostego systemu komputerowego do testowania przetwarzania informacji (i piszą, że wcześniejsza literatura wspiera ekstrapolację od takiego prostego podejmowania decyzji do bardziej skomplikowanego). Badani oglądali kropki na krótko pojawiające się na ekranie. Wiele kropek poruszało się w jednym kierunku, mniejszość poruszała się w drugim kierunku, a inny podzbiór poruszał się losowo. Zadaniem było ustalenie ruchu netto kropek – poprawne dostrzeżenie właściwego kierunku, w jakim poruszała się większość kropek. Dla każdego badanego proporcje były zmieniane i kalibrowane tak, że badany mógł być bardziej lub mniej pewien swojego wyboru, zachowując tę samą poprawność. Badanie przeszli następnie przez wiele prób wskazując zarówno kierunek ruchu (lewo lub prawo) i ruchomą skalę ich pewności.

Po tym jak badany dokonał wyboru w jednej próbie, pokazywano mu inny zestaw kropek poruszających się w tym samym kierunku (tak zwaną próbę potwierdzającą), ale łatwiejszą do wykrycia. Wolno im było wtedy zmienić swój pierwotny wybór. Badani, których pierwsza decyzja nie była poprawna i którzy mieli niskie poczucie pewności, mogli zmienić swoją decyzję, kiedy przedstawiono im bardziej oczywistą informację. Ci, których decyzja nie była poprawna, ale mieli wysokie poczucie pewności, mniej chętnie zmieniali swój początkowy, błędny wybór, kiedy otrzymywali bardziej oczywistą informację. Poczucie pewności miało negatywny wpływ na poprawianie swoich obserwacji.

To nie jest zaskakujące, ale jest to sprytny sposób pokazania tego efektu. Następna część badania jest jednak może bardziej interesująca. Części prób dokonywano używając magnetoencefalografii (MEG), żeby widzieć aktywność mózgu podczas procesu podejmowania decyzji. Jeden obszar mózgu, środkowy płat ciemieniowy wykazywał aktywność podczas oglądania poruszających się kropek. Ta część mózgu jest zaangażowana w przetwarzanie informacji, więc aktywność w tym miejscu ma sens do tego zadania. Jednak, kiedy badani mylili się, mając wysoką pewność, nie wykazywali aktywności w tym obszarze mózgu, kiedy oglądali kolejną informację, zaprzeczającą ich przekonaniu. To sugeruje, że efekt potwierdzenia działa częściowo przez nieprzetwarzanie informacji, która jest sprzeczna z wyznawanym poglądem. Ta informacja zostaje zignorowana.

To jest całkiem mocne. Nie potrzebujemy nawet marnować energii na wyjaśnianie, dlaczego informację trzeba odrzucić – w ogóle jej nie dostrzegamy.

Oczywiście nie jest to jedyny mechanizm efektu potwierdzenia. Pewnych informacji nie można ignorować. Wcześniejsze badania sugerują, że głównym mechanizmem efektu potwierdzenia jest racjonalizacja informacji, która nie pasuje do naszego modelu i selektywne zapominanie jej lub etykietkowanie jej jako „wyjątku” od reguły. Ale, przynajmniej w tym paradygmacie, możemy także odfiltrować taką informację z naszego postrzegania.

Co więc możemy z tym zrobić? Sceptycyzm nie polega tylko na identyfikowaniu problemów, ale na proponowaniu środków zaradczych. W nauce głównym mechanizmem jest używanie standardyzowanych, rygorystycznych metod, które nie pozwalają na wpływ błędów poznawczych (takich jak podwójnie ślepa próba). Naukowe badania muszą uwzględniać wszystkie dane, nie zaś traktować je wybiórczo. Metody trzeba ustalić na początku i nie zmieniać ich w trakcie badania. Nie trzymanie się tych rygorystycznych metod pozwala na wpełznięcie efektu potwierdzenia i unieważnia wyniki.

Co jednak z naszym codziennym doświadczeniem? Nie możemy żyć tak, jakbyśmy prowadzili rygorystyczne badanie naukowe. Jednym z głównych środków zaradczych, jakich możemy użyć, jest pokora i to badanie wzmacnia tę tezę. (Pisałem o tym wcześniej jako o neuropsychologicznej pokorze – pokorze zrodzonej ze zrozumienia ograniczeń naszych mózgów.) Jest to także część tego, co nazywamy metapoznaniem – myśleniem o samym myśleniu. Jeśli wiemy, że efekt potwierdzenia może wyprowadzić nas na manowce, to musimy być pokorni przy wyciąganiu wniosków. Musimy zawsze zajmować stanowisko, że możemy się mylić. Pomaga także umieszczanie procesu i obiektywnej informacji powyżej każdego konkretnego wniosku.

To znaczy, że nie eliminujemy ludzkich emocji, ale rozumiemy je i powodujemy, że działają dla nas w produktywny sposób. Jeśli więc czerpiemy dumę z własnej pokory, tego, że nie przywiązujemy się do żadnego sztywnego wniosku, z elastyczności wobec nowej informacji, daje nam to emocjonalną przestrzeń do autokorekty. Nie jest wstydem powiedzenie „nie miałem racji”; w obliczu nowych informacji, nowego argumentu lub punktu widzenia „zmienię moje zdanie”. W rzeczywistości, zmiana zdania staje się sceptycznym medalem honoru.

Naświetla to także pułapki zajmowania skrajnych stanowisk ideologicznych. Skrajne ideologie umieszczają czystą moralnie narrację powyżej rzeczywistości. Podczas gdy umiarkowane stanowisko rodzi się na ogół z tendencji do widzenia wszystkich stron i przyznawania siły i słabości różnych stanowisk. To nie znaczy, że stanowisko „pośrodku” zawsze jest poprawne lub lepsze – to jest nie zrozumieniem tego, co znaczy być umiarkowanym. Umiarkowane stanowisko po prostu umieszcza fakty i logikę powyżej ideologii. A także, w wielu wypadkach „różne strony” w jakiejś sprawie mogą być skrajnie asymetryczne. Czasami jedna strona po prostu nie ma racji. Rzadko kiedy jednak ta sama strona zawsze myli się, a nawet jeśli myli się, może mieć istotny argument (choć pociąga go zbyt daleko).

W pewien sposób bycie umiarkowanym, pokornym i sceptycznym oznacza ustawienie się w pozycji obiektywnego sędziego w meczu. Nie możesz dbać o to, która strona wygra, ale zamiast tego musisz liczyć piłki i uderzenia tak, jak je widzisz. A jeśli sfilmowana powtórka pokazuje ci, że źle zobaczyłeś, to poprawiasz to i czerpiesz dumę z faktu, że mogłeś to zrobić z pokorą.

Confidence Drives Confirmation Bias

NeuroLogica Blog, 28 maja 2020

Tłumaczenie: Małgorzata Koraszewska

Neurolog, wykładowca na Yale University School of Medicine. Przewodniczący i współzałożyciel New England Skeptical Society. Twórca popularnych (cotygodniowych) podkastów o nauce The Skeptics’ Guide to the Universe. Jest również dyrektorem Science-Based Medicine będącej częścią James Randi Educational Foundation (JREF), członek Committee for Skeptical Inquiry (CSI) oraz członek założyciel Institute for Science in Medicine. Prowadzi blog Neurologica.