O marnej powtarzalności badań psychologicznych

Jeszcze przed opublikowaniem tego artykułu twierdziłem, że ludzie powinni robić w biologii to, co ci ludzie zrobili w psychologii: testować wyniki eksperymentów, które są imponujące, ale rzadko powtarzane. W psychologii, podobnie jak w biologii ewolucyjnej i ekologii, znaczące odkrycia nie są często powtarzane, bo zrobienie tego wymaga trudnych do zdobycia pieniędzy i wspólnych wysiłków – wysiłków, które nie zostają nagrodzone. (Nie masz wielkiej satysfakcji ani zawodowych osiągnięć po prostu przez powtórzenie pracy kogoś innego.) Ponadto w biologii (i przypuszczalnie w psychologii eksperymentalnej) praca nie jest często powtarzana jako normalny produkt uboczny budowania na poprzednich wynikach. Na przykład, jeśli chcesz użyć nowej metody zastąpienia genu, musisz pośrednio zreplikować protokoły innych ludzi, zanim zaczniesz wstawiać własny, ulubiony gen.

Sądzę więc, że około połowy opublikowanych badań w mojej dziedzinie (włączam tu ekologię obok ewolucji) prawdopodobnie nie dałoby takich samych wyników przy powtórzeniu ich. Wyłączam te badania, które używają genetyki, jako że prace genetyczne łatwo powtórzyć, szczególnie jeśli dotyczą sekwencjonowania DNA.

Niepowodzenie w powtórzeniu opublikowanego wyniku nie znaczy, że eksperymentatorzy oszukiwali ani nawet, że ich praca zawiera błędy. Może to znaczyć, na przykład, że wyniki są swoiste dla danego miejsca, czasu lub zestawu eksperymentalnego albo, że istnieje tendencja publikowania imponujących wyników, a więc publikuje się tylko takie, których wyniki mają wysoką istotność statystyczną. Wreszcie, przy 0,05 jako konwencjonalnej granicy prawdopodobieństwa, 5% wszystkich eksperymentów da istotne odchylenie od szansy (falsyfikując tym hipotezę zerową), nawet kiedy hipoteza zerowa jest prawdziwa.

Przejdźmy do eksperymentu. OSC postanowiła sprawdzić powtarzalność w dość rygorystyczny sposób. Cała grupa ludzi zgodziła się przetestować dużą liczbę prac wziętych z trzech pism, kończąc ze stoma powtórzonymi eksperymentami. Aby narzucić rygor, wybrali tylko prace publikowane w wiodących pismach, powtórzyli tylko ostatnie badanie z każdej pracy (żeby nie replikować wstępnych wyników, które często są pierwsze publikowane), a następnie powtórzyli każde badanie w tak identyczny sposób z oryginalnym badaniem, jak było to możliwe – z wyjątkiem tego, że mieli większe próby, co dawało im większe szanse wykrycia efektów.

Zasługą oryginalnych autorów jest to, że dostarczyli zespołowi OSC kompletnych danych i szczegółów swoich eksperymentów, zapewniając, że powtórzenia były przeprowadzone w tak podobny sposób do oryginalnych badań, jak to możliwe. Było tam jeszcze wiele innych kontroli, włącznie z zaangażowaniem statystyków, by niezależnie powtórzyli wyliczenia wartości prawdopodobieństwa dla powtarzanych eksperymentów.

Rezultaty wszystkich oryginalnych badań były statystycznie istotne, z wartościami p (tj. szansą na otrzymanie zaobserwowanego efektu jako wyłącznie statystycznej obserwacji odstającej, kiedy nie ma żadnego realnego efektu) poniżej 5% (kilka były odrobinę wyższe). Kiedy szansa otrzymania fałszywego wyniku pozytywnego wynosi 0,05 lub mniej, badacze uważają wynik za „istotny statystycznie”, co jest kluczem do tego, że praca zostanie opublikowana. Oczywiście, ta granica jest arbitralna i jest niższa w dziedzinach takich jak fizyka, a przy eksperymentach typu wykrywanie bozonu Higgsa spada do 0,00001.

Co więc stało się, kiedy powtórzono te 100 badań psychologicznych? Wynikło z tego, że większość istotnych rezultatów stała się nieistotna, a efekty, które znaleziono, nawet jeśli nieistotne, spadły do około połowy efektów, o których informowano w oryginalnych pracach. Tutaj są rezultaty:

- Tylko 35 z oryginalnych 100 eksperymentów dało statystycznie istotne wyniki przy powtórzeniu (62 nie dały, a trzy zostały wykluczone). Innymi słowy, przy powtórzeniu w niemal identycznych warunkach i często przy wyższej próbie, tylko 35 oryginalnych wyników uznano za istotne.

- To powiedziawszy, wiele (ale zdecydowanie nie wszystkie) wyniki wskazywały w tym samym kierunku jak w badaniu oryginalnym, ale nie były wystarczająco duże, by osiągnąć istotność statystyczną. Gdyby te powtórki były oryginalnymi pracami, większość prawdopodobnie nie zostałaby opublikowana.

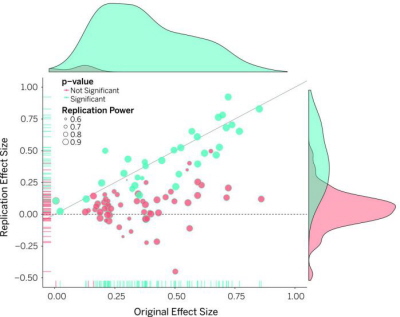

Tutaj jest wykres pokazujący korelację między wartościami p w oryginalnych pracach i w powtórzeniach. Każdy punkt przedstawia rozmiar efektu widzianego w powtórce (oś Y) wobec rozmiaru efektu w tym samym oryginalnym badaniu (oś X). Jeśli punkt jest zielony, powtórka była także statystycznie istotna (jak też efekty w badaniu oryginalnym). Różowe punkty oznaczają, że powtórka nie dała statystycznie istotnych wyników. Pokazuje to, że rozmiar efektu był ogólnie niższy niż w badaniach oryginalnych (większość punktów znajduje się poniżej linii ukośnej) i większość powtórek (dokładnie, 62%) nie pokazała istotnych efektów.

Wykres pokazuje także, że im większy efekt obserwowany w oryginalnym badaniu, tym bardziej prawdopodobne, że zostanie on powtórzony, bo różowe punkty gromadzą się po lewej stronie wykresu, gdzie rozmiary oryginalnych efektów są niewielkie. Zgadza się to z odkryciem badaczy, że im niższa wartość p w oryginalnym eksperymencie, co oznacza bardziej istotny wynik, tym większe prawdopodobieństwo, że będzie on także istotny w powtórce.

- Choć większość wyników w powtórzonych badaniach szła w tym samym kierunku, co w badaniu oryginalnym, była znaczna liczba (doliczyłem się 20%), które albo wskazywały w innym kierunku, albo w ogóle nie pokazywały żadnego efektu. A proszę pamiętać, że nawet jeśli nie ma rzeczywistego efektu biologicznego w oryginalnym badaniu, połowa powtórzeń będzie, wyłącznie losowo, pokazywać ten sam kierunek co badanie oryginalne.

- Zespół OSC zapytał także każdy zespół dokonujący powtórki eksperymentu, czy uważają, że ich wyniki rzeczywiście powtórzyły rezultaty oryginalnego badania. Ta ocean jest subiektywna, ale odzwierciedlała wyniki oparte na istotności wartości p: tylko 39% badaczy uznało, że ich wyniki powtórzyły wyniki badania oryginalnego.

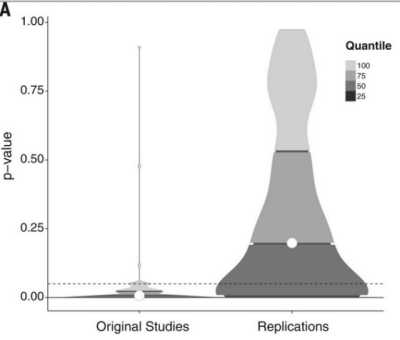

- Wreszcie, jest możliwe, że wartości p w powtórkach dochodziły blisko do magicznej granicy p = 0,05, która jest oczywiście mniej lub bardziej arbitralnym progiem istotności. Żeby zobaczyć, czy tak jest, autorzy zrobili wykres gęstości wartości p w badaniach oryginalnych kontra te, które znaleziono w powtórkach. Tutaj są wyniki, z wartościami p z badań oryginalnych po lewej i z powtórek po prawej.

Co to wszystko znaczy?

Istnieją dwa, diametralnie sprzeczne poglądy na to, jak zareagować na tę ogólną porażkę przy powtórkach. Pierwszym jest świętowanie tego jako zwycięstwa nauki. W końcu, nauka jest nieustannym sprawdzaniem własnych wniosków, a można to zrobić tylko przez sprawdzanie, czy to, co znaleźli inni ludzie, rzeczywiście jest słuszne. I do takiego wniosku dochodzą autorzy. Cytuje z ich artykułu:

Postęp w nauce jest kumulatywnym procesem zmniejszania niepewności, który może udać się tylko wtedy, kiedy sama nauka pozostaje największym sceptykiem co do własnych twierdzeń wyjaśniających.

Przedstawione wyniki sugerują, że należy ulepszyć powtarzalność w psychologii. Każda pokusa interpretowania tych wyników jako porażki dla psychologii lub ogólnie dla nauki, musi stawić czoła faktowi, że ten projekt pokazuje naukę, która zachowuje się tak, jak powinna. Pełno jest hipotez, że obecna kultura w nauce może wpływać negatywnie na powtarzalność odkryć. Odpowiedź ideologiczna pominęłaby argumenty, zdyskredytowała źródła i radośnie kontynuowała tą samą drogą. Proces naukowy nie jest ideologiczny. Nauka nie zawsze mówi to, co chcielibyśmy usłyszeć; konfrontuje nas z tym, co jest. Ponadto, jak to pokazuje Transparency and Openness Promotion (TOP) Guidelines, społeczność badaczy już podejmuje działania, by poprawić jakość i wiarygodność literatury naukowej.

Przeprowadziliśmy ten projekt, ponieważ głęboko obchodzi nas zdrowie naszej dyscypliny i wierzymy w jej obietnicę, że zgromadzenie wiedzy o zachowaniu ludzkim może podnieść jakość życia ludzkiego. Powtarzalność jest kluczowa dla tego celu. Gromadzenie dowodów jest metodą autokorekty społeczności naukowej i najlepszą dostępną opcją osiągnięcia ostatecznego celu: prawdy.

Jest w tym, oczywiście, bardzo dużo sensu. Wynik nie zostaje szeroko akceptowany (w większości dziedzin), dopóki nie zostanie powtórzony, albo uczyni konkretne przewidywania, które można przetestować. Autokorekta jest także silna – jest to jedna z najważniejszych cech nauki, która odróżnia ją od, na przykład, teologii.

Interpretację “w nauce wszystko jest w porządku” promowała także Lisa Feldman Barrett w nowym artykule o tym badaniu w „New York Times” - Psychology is not in crisis. (Barrett jest profesorem psychologii w Northeastern University.) Ale jej artykuł jest bezładny, porównujący niepowodzenie powtórzenia badań psychologicznych ze zmieniającym się środowiskiem, w jakim gen ulega ekspresji. W niektórych środowiskach, pisze ona, gen dający kędzierzawe skrzydła, czyni skrzydła mniej kędzierzawymi, co jest powszechnym zjawiskiem, które my, genetycy, nazywamy „zmienną ekspresyjnością”. Istotnie tak jest, ale nie znaczy to, że mutacja „kędzierzawa” nie powoduje, że skrzydło jest kędzierzawe – a to ona sugeruje. Zmienna ekspresyjność nie jest niepowodzeniem powtórzenia odkrycia, że dana mutacja genu jest odpowiedzialna za kędzierzawe skrzydła.

Barrett porównuje również niepowodzenie powtórzenia badań przez OSC z innymi badaniami, w których niepowodzenie powtórzenia zależy od „kontekstu” (np. myszy, które poddaje się wstrząsowi, kiedy słyszą dźwięk, rozwijają odruch Pawłowa), a więc nie widzimy tego samego rezultatu w innych warunkach (myszy nie rozwiną odruchu Pawłowa, jeśli są przywiązane podczas wstrząsu). To jednak, podobnie jak kędzierzawe skrzydła, nie ma nic wspólnego z pracą OSC, która próbowała zapewnić, że kontekst i warunki eksperymentalne były tak bliskie oryginalnym badaniom jak to możliwe. Innymi słowy, zespół OSC próbował wyeliminować efekty zależne od kontekstu. W pragnieniu obrony i uniewinnienia swojej dziedziny i zatwierdzenia siły nauki Barrett przedstawia argumenty oparte na fałszywych analogiach.

Wszyscy możemy się zgodzić co do jednej rzeczy – że istnieje problem z kulturą nauki, która zawsze przedkłada duże i imponujące rezultaty pozytywne nad rezultaty negatywne i faworyzuje publikacje nowych rezultatów, ignorując próby ich replikacji. (Czasami niepowodzenie powtórzenia badań nie jest w ogóle akceptowane przez pismo naukowe!) Jest to jeszcze wyraźniejsze w prasie popularnej, która jest szybka w roztrąbieniu spraw takich jak „gen geja”, ale nie kłopocze się publikowaniem zastrzeżeń i odwołań, kiedy – jak w tym wypadku – nie można było powtórzyć tego wyniku w kolejnym badaniu. Ten problem, przynajmniej w kulturze naukowej, można nieco naprawić. Najważniejsze: potrzebujemy więcej badań takich jak OSC, ale powtórzeń zastosowanych do innych dziedzin, szczególnie biologii.

I to doprowadza mnie do ostatniego punktu, który daje mniej pozytywny pogląd na rezultaty. Jak powiedziałem powyżej, sądzę, że wiele badań w biologii – szczególnie biologii organizmów – nie jest powtarzana, zwłaszcza, jeśli wymaga pracy w terenie. Takie badania pozostają więc w literaturze, choć nigdy nie były sprawdzone, a często stają się klasycznymi pracami, które wchodzą do podręczników.

W ten sposób biologia przypomina psychologię, chociaż badania w biologii molekularnej i biologii komórek często są powtarzane jako część trwającego postępu w tej dziedzinie. Sądzę więc, że błędne jest twierdzenie, iż ekologia i ewolucja mają ten sam stopień autokorekty, jak, powiedzmy, fizyka i chemia. Tak, każda praca powinna być w zasadzie sprawdzona, ale znajdziesz bardzo niewiele dolarów wręczonych przez National Institutes of Health lub National Science Foundation do powtórzenia prac w biologii. (Jest tak, ponieważ w ogóle nie ma zbyt dużo pieniędzy do wręczania!) W mojej dziedzinie, biologii organizmów, mechanizm autokorekty, chociaż działa na pewnym poziomie, nie jest nawet w przybliżeniu tak silny jak w innych dziedzinach, takich jak biologia molekularna i biologia komórek.

Moim głównym wnioskiem jest więc, że potrzebujemy OSC dla ekologii i biologii ewolucyjnej. Ale będzie mróz w lipcu (w Arizonie), jeśli to się zdarzy!

_______

Open Science Collaboration. 2015. Estimating the reproducibility of psychological science. Science, 349 online, DOI: 10.1126/science.aac4716

On the irreproducibility of psychology studies

Why Evolution Is True, 3 września 2015

Tłumaczenie: Małgorzata Koraszewska

Profesor na wydziale ekologii i ewolucji University of Chicago, jego książka "Why Evolution is True" (Polskie wydanie: "Ewolucja jest faktem", Prószyński i Ska, 2009r.) została przełożona na kilkanaście języków, a przez Richarda Dawkinsa jest oceniana jako najlepsza książka o ewolucji. Jerry Coyne jest jednym z najlepszych na świecie specjalistów od specjacji, rozdzielania się gatunków. Jest wielkim miłośnikiem kotów i osobistym przyjacielem redaktor naczelnej.